Volker schrieb:

Ja so funktioniert die Rechnung aber oft nicht.

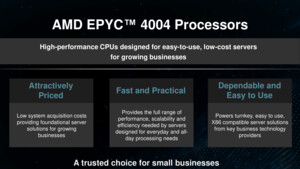

Stimmt schon, aber man muss schauen, wo diese Rechnung durchaus stimmen kann. Bei uns in den Rechenzentren würde das zum Teil wunderbar hinauen, da wir nicht unbedingt mehr Leistung brauchen und ein oder zwei Server mit hier 128 oder gar 256 Kernen locker das halbe Rechenzentrum ablösen könnten, wäre da nicht ein kleiner Umstand.

Deswegen schrieb ich ja auch: Allgemein sollten wir über die Umweltfreundlichkeit einer neuen CPU lieber nicht schreiben, denn das fängt ja bereits mit der Herstellung an.

LamaMitHut schrieb:

Was meinst du denn, welche Materialschlacht heute für so viel Leistung geführt werden müsste?

Das Problem ist, dass diese Materialschlacht auch mit den neuen CPUs geführt wird. Nur das diese Materialschlacht zu mehr Rechenleistung führt. Volker hat da schon recht. Nich jeder denkt da wie ich gerade oder andere in der IT, die nur eine gewisse Rechenleistung brauchen und damit eher Server ersetzen würden, weil uns das günstiger kommt am Ende.

Ich hab einen Betrag X pro Jahr, denn ich ausgeben darf, davon muss ich sehr viel abdecken und wenn ich da Geld sparen kann: Mach ich das! Wenn man aber wie die großen Unternehmen quasi immer mehr Rechenleistung braucht, dann versucht man nicht zu sparen, sondern gibt es einfach aus.

Herdware schrieb:

Wenn der Bedarf an Rechenleistung immer weiter wächst, kann man aber schlecht den CPU-Herstellern die Schuld dafür geben.

Nein, das stimmt schon, denen kann man nicht die Schuld geben. Allgemein sollte wir aber manche Sachen aktuell auch mal hinterfragen!

Salutos schrieb:

Naja, wenn der Stromverbrauch (dummer Client) in der Fläche, beim Verbraucher, in gleichem Maße zurückgeht wäre das ja kein Problem.

Geht er aber leider nicht und mit den ganze Cloud-Systemen wird zwar ein Teil der Rechenleistung verlagert, gleichzeitig hast du aber immer noch teilweise recht "mächtige" Thin-Clients die gut Strom verballern und da du nun vieles über die Datenleitungen schickst, hat man da auch gleich mehr Energie, die benötigt wird.

[wege]mini schrieb:

Die Softwareheinis sind schuld. Die sind unfähig.

Du glaubst nicht, wie nah du mit dieser Aussage der Wahrheit kommst. Wir haben doch hier mit der News zu ElevenClock schon so ein Beispiel. Ließ dir mal die Verbesserunghen der ElevenClock durch und was da für Ressourcen im Rechner aufgewendet werden müssen um auf dem 2, 3 oder 4. Display eine Uhr anzuzeigen.

Und warum? Weil der Schüler zwar das "Problem" der fehlenden Uhr lösen kann, dafür aber in dem Fall den schlechtesten Weg geht, den man da gehen kann: Skriptsprache, die über einen Interpreter läuft und damit viel Overhead erzeugt.

Und ähnlich sicht es auch heute auf den Servern teilweise aus, wenn es m Rechenleistung geht, da verpufft sehr viel Rechenleistung auch in den Skriptsprachen, weil die Skriptsprache hip und einfach ist, während eine andere Sprache besser geeignet wäre und weniger Overhead erzeugt.

Ich merke das ja an mir selbst auch immer etwas, dass ich manchmal aus Bequemlichkeit den einfachen weg gehe, damit aber auch Ressource verschenke, weil sie eben da sind.