bei den erzielten Werten von Anandtech nehme ich an, dass es sich bereits um ein 12 Shader Modell gehandelt hat.

Was aber ebenfalls interessant wäre, ist ob der Turbo nun aktiv oder nicht aktiv war, da dieser bereits für bis 58% Leistungssteigerung auf der GPU sorgen könnte.

Anandtech sieht das in einem Update ähnlich:

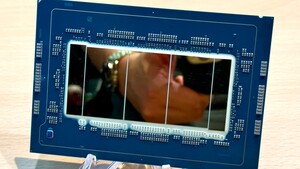

On the GPU side, the part I’m testing appears to be the single-core GPU configuration (6 EUs). Intel hasn’t released any info as to what parts will get the dual-core/12 EUs GPU configurations, although it may make sense for Intel to use the 12 EU parts in notebooks given the importance of integrated graphics to the mobile market. Update: The part we're looking at may actually have been a lower clocked 12 EU part, we're still waiting for additional confirmation.

Da der Turbo bei der CPU inaktiv war, bei Turbo 2.0 jedoch GPU und CPU Takt teil der Turbofunktion sind, ist es wahrscheinlich, dass man ca 50% Leistungssteigerung noch addieren muss da er inaktiv war.

Mit 32nm scheint auch Quadcore endgültig im mobilen Bereich angekommen zu sein. Bei niedrigem Grundtakt spielt der Turbo aber zunehmend eine wichtigere Rolle. 3,2 Ghz sind für das kleinste Modell schon verdamm viel...

Persönlich reichen mir im Notebook allerdings zwei Kerne / 4 Threads aus.

Für Spieler und andere Anwender mit höherem Anspruch an die Grafikleistung werden diskrete Lösungen aber nach wie vor unentbehrlich bleiben.

so sehe ich das auch.

Augenmerk sollte nach wie vor auf CPU, nicht auf GPU Leistung liegen. Wenn hier bei Sandy Bridge "nur" 20% IPC erreicht werden, wonach es aussieht wenn man dem Test glauben schenken darf, dann ist der Core i5 2520M | 2 / 4 | 2,5 / 3,2 GHz so schnell wie ein 3 Ghz / 3,82 Ghz Arrandale.

20% sehe ich als realistisch an, da Arrandale wie Clarkdale nicht an die IPC der normalen Nehalem Architektur herankommt, ein paar % aufgrund des in der GPU sitzenden Speicherinterface bzw die dadurch hohen Latenzen, abgeben muss. Sandy Bridge sollte dieses Problem beseitigen, da eine SingelChip Lösung.

Edit:

Nicht vergessen darf man, dass die TDP immer weniger mit dem Durchschnittsverbrauch aufgewogen werden kann und somit immer geringere Aussagekraft bezüglich des Energieverbrauchs liefert.

Bei den Quad Cores müssten alle 8 Threads voll belastet werden, was unter normalen Umständen so gut wie nie vorkommt. Selbst volle 4 Kern Auslastung ist eher selten.

Was auftreten sind einzelne "Last-Peaks" beim starten von Programme, normalen Operationen, beim Booten etc. Hier greift der Turbo - aber im Schnitt dürfte die Last bei unter 15% liegen.